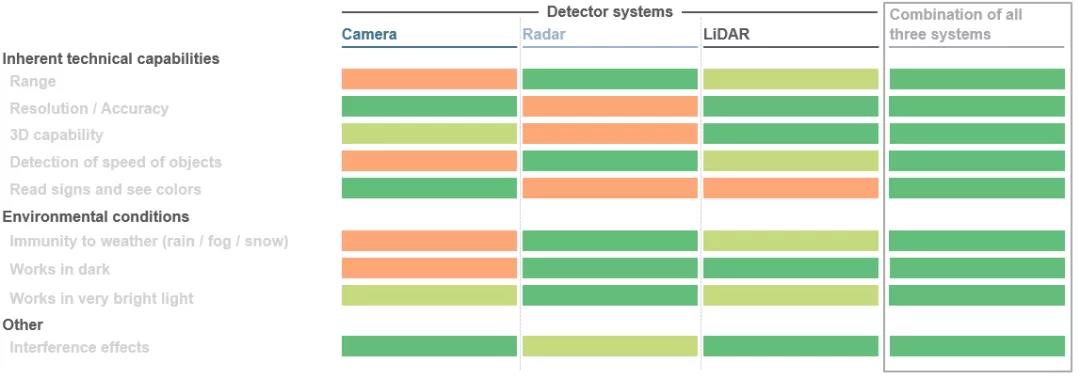

Ett stort steg pågår inom rörligheten. Detta gäller oavsett om det är inom fordonssektorn, där lösningar för autonom körning utvecklas, eller i industriella tillämpningar som använder robotik och automatiserade styrda fordon. De olika komponenterna i hela systemet ska samverka med varandra och komplettera varandra. Huvudmålet är att skapa en sömlös 3D-vy runt fordonet, använda denna bild för att beräkna objektavstånd och initiera nästa drag av fordonet med hjälp av speciella algoritmer. Faktum är att tre sensorteknologier används samtidigt här: LiDAR (LiDAR), radar och kameror. Beroende på det specifika applikationsscenariot har dessa tre sensorer sina egna fördelar. Att kombinera dessa fördelar med redundant data kan förbättra säkerheten avsevärt. Ju bättre dessa aspekter är samordnade, desto bättre kommer den självkörande bilen att kunna navigera i sin miljö.

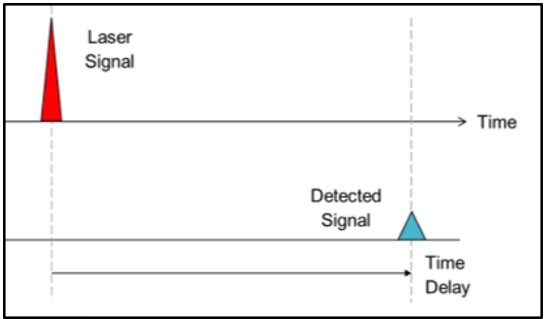

1. Direkt flygtid (dToF):

När det gäller flygtiden använder systemtillverkare ljusets hastighet för att generera djupinformation. Kort sagt skjuts riktade ljuspulser ut i omgivningen och när ljuspulsen träffar ett föremål reflekteras den och registreras av en detektor nära ljuskällan. Genom att mäta tiden det tar för strålen att nå objektet och återvända kan objektavståndet bestämmas, medan i dToF-metoden kan avståndet för en enda pixel bestämmas. De mottagna signalerna bearbetas slutligen för att utlösa motsvarande åtgärder, såsom undanmanövrar för fordon för att undvika kollisioner med fotgängare eller hinder. Denna metod kallas direkt flygtid (dToF) eftersom den är relaterad till strålens exakta "tidpunkt för flygning". LiDAR-system för autonoma fordon är ett typiskt exempel på dToF-applikationer.

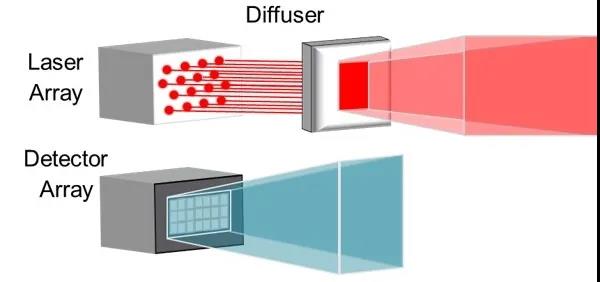

2. Indirekt flygtid (iToF):

Den indirekta flygtiden (iToF) är liknande, men med en anmärkningsvärd skillnad. Belysning från en ljuskälla (vanligtvis en infraröd VCSEL) förstärks av ett duckark och pulser (50 % arbetscykel) sänds ut till ett definierat synfält.

I nedströmssystemet kommer en lagrad "standardsignal" att utlösa detektorn under en viss tid om ljuset inte stöter på ett hinder. Om ett objekt avbryter denna standardsignal kan systemet bestämma djupinformationen för varje definierad pixel i detektorn baserat på den resulterande fasförskjutningen och pulstågets tidsfördröjning.

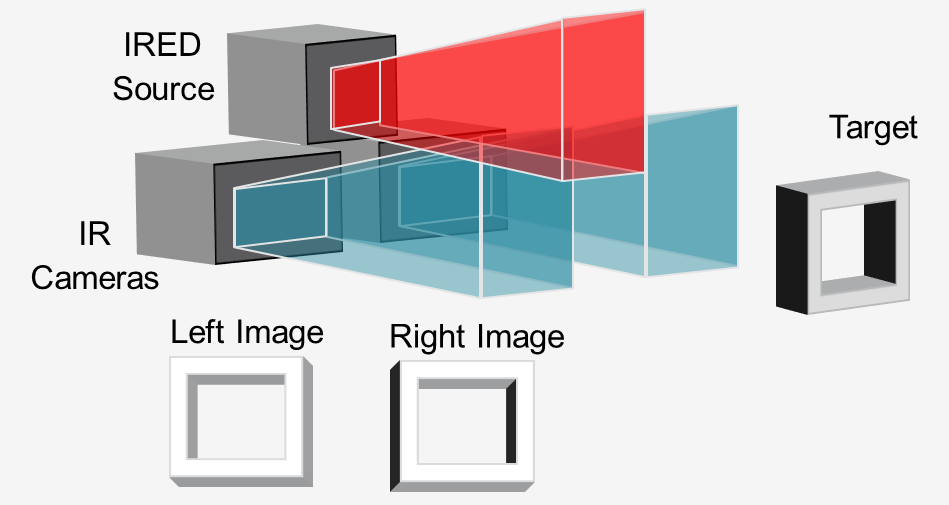

3. Active Stereo Vision (ASV)

I metoden "active stereo vision" lyser en infraröd ljuskälla (vanligtvis en VCSEL eller IRED) upp scenen med ett mönster, och två infraröda kameror spelar in bilden i stereo.

Genom att jämföra de två bilderna kan nedströmsmjukvara beräkna den nödvändiga djupinformationen. Ljus stöder djupberäkningar genom att projicera ett mönster, även på föremål med liten struktur som väggar, golv och bord. Detta tillvägagångssätt är idealiskt för näravstånd, högupplöst 3D-avkänning på robotar och automatiserade vägledda fordon (AGV) för att undvika hinder.

Copyright @ 2020 Shenzhen Box Optronics Technology Co., Ltd. - China Fiber Optic Modules, Fiber Coupled Lasers Manufacturer, Laser Components Leverantörer alla rättigheter reserverade.